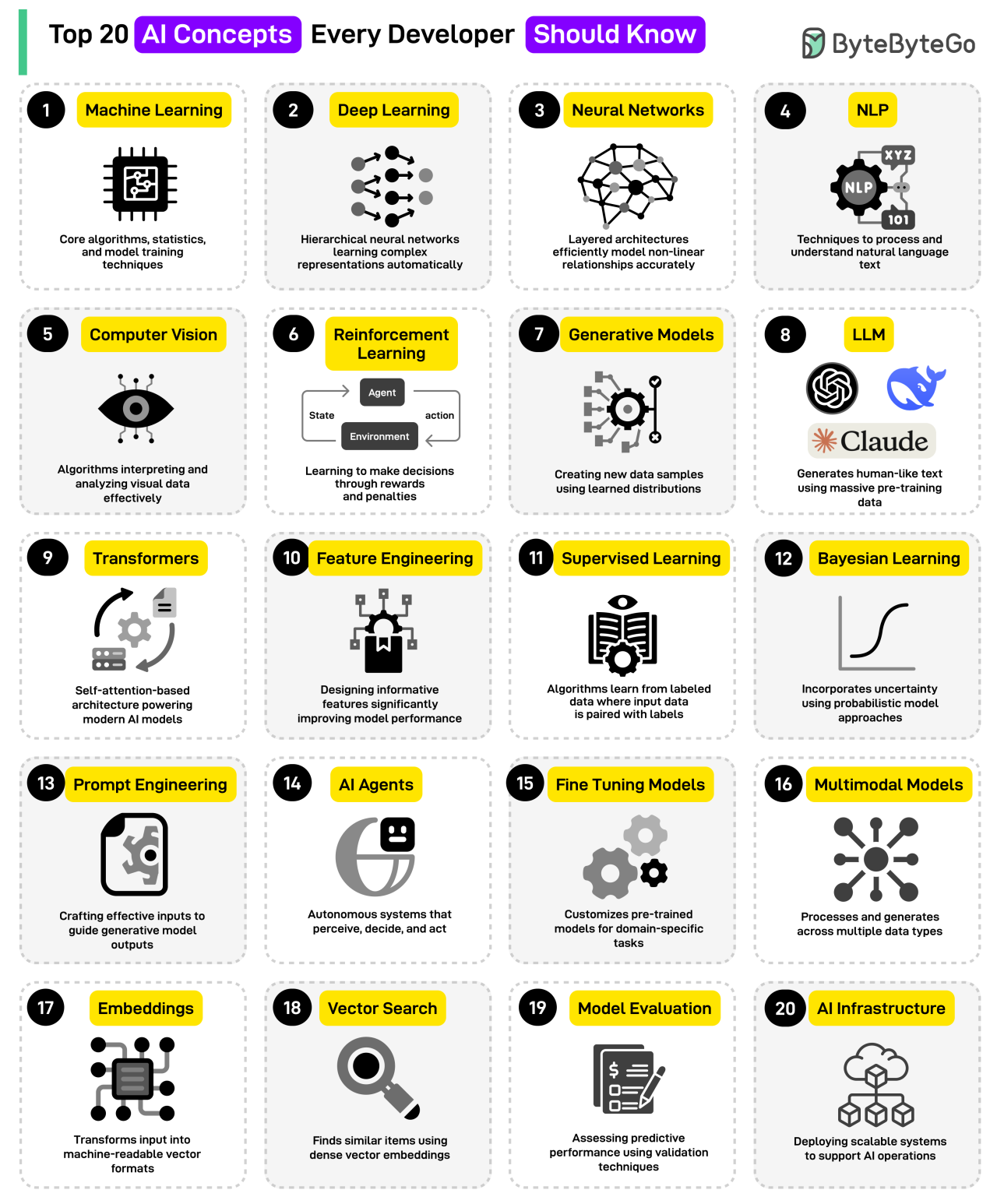

20 concepts IA à connaître

Découvrez 20 concepts clés de l'IA, du Machine Learning aux LLMs, expliqués simplement avec des exemples concrets.

1. Machine Learning (apprentissage automatique)

Ensemble d'algorithmes et de techniques statistiques permettant aux systèmes d'"apprendre" à partir de données pour effectuer des prédictions ou prendre des décisions sans être explicitement programmés.

Exemples

- Un modèle prédictif pour les ventes basé sur l'historique des données.

- Un filtre anti-spam qui s'adapte aux nouveaux types de courriels indésirables.

- Reconnaissance d'images (ex. : classer des photos de chats et de chiens).

2. Deep Learning (apprentissage profond)

Sous-domaine du machine learning utilisant des réseaux de neurones artificiels à multiples couches pour extraire des caractéristiques complexes des données de manière hiérarchique et automatique.

Exemples

- Reconnaissance vocale (ex. : assistants comme Siri ou Alexa).

- Traduction automatique (ex. : Google Translate).

- Voitures autonomes (analyse des images des caméras en temps réel).

3. Neural Networks (réseau de neurones artificiels)

Architectures inspirées du cerveau humain, composées de couches de "neurones" interconnectés qui traitent des données pour reconnaître des motifs ou effectuer des prédictions via des calculs non linéaires.

Exemples

- Reconnaissance d'écriture (ex. : scan de chèques bancaires).

- Recommandations personnalisées (ex. : Netflix, Spotify).

- Diagnostics médicaux (ex. : détection de tumeurs sur des IRM).

4. NLP ou natural language processing (traitement automatique des langues)

Ensemble de techniques permettant aux machines de comprendre, interpréter et générer du langage humain (écrit ou parlé) de manière intelligente.

Exemples

- Chatbots (ex. : assistants virtuels comme ChatGPT).

- Analyse de sentiments (ex. : évaluer l'opinion sur les réseaux sociaux).

- Résumé automatique (ex. : synthétiser un article long en quelques lignes).

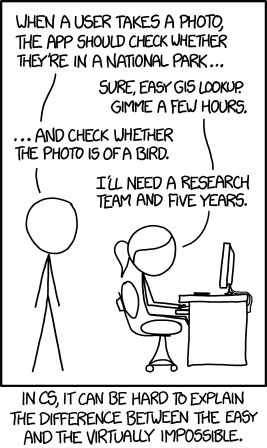

5. Computer Vision (vision par ordinateur)

Champ de l'IA qui permet aux machines d'analyser, traiter et interpréter des données visuelles (images, vidéos) pour prendre des décisions ou extraire des informations. Les avancées récentes dans ce domaine sont largement portées par le deep learning, notamment grâce aux architectures de réseaux neuronaux convolutifs (CNN) capables d'apprendre des caractéristiques visuelles hiérarchiques directement à partir des pixels.

Exemples

- Reconnaissance faciale (ex. : déverrouillage du smartphone par Face ID) utilisant des CNN profonds pour extraire des motifs faciaux complexes.

- Détection d'objets (ex. : voitures autonomes identifiant les piétons) via des modèles comme YOLO ou Faster R-CNN, basés sur le deep learning.

- Imagerie médicale (ex. : détection de fractures sur des radiographies) où les réseaux neuronaux surpassent les méthodes traditionnelles en précision.

6. Reinforcement Learning (apprentissage par renforcement)

Méthode d'IA où un agent apprend à prendre des décisions optimales en interagissant avec un environnement, via des récompenses (succès) ou des pénalités (échecs).

Exemples

- Jeux vidéo (ex. : AlphaGo battant les champions de Go).

- Robotique (ex. : un robot apprenant à marcher par essai-erreur).

- Optimisation de flux (ex. : gestion intelligente de feux de circulation).

7. Generative Models (modèle génératif)

Algorithmes capables de créer de nouvelles données (images, texte, sons) similaires à celles d'un ensemble d'apprentissage, en capturant leurs motifs statistiques.

Exemples

- Génération d'images (ex. : DALL·E créant des artworks à partir de descriptions).

- Synthèse vocale (ex. : voix IA réalistes comme celles de Gemini TTS).

- Augmentation de données (ex. : création de faux visages pour entraîner des modèles).

8. LLM ou large language model (grand modèle de langage)

Modèles d'IA entraînés sur d'immenses volumes de texte pour comprendre, générer et manipuler du langage humain avec une grande cohérence. Ces modèles reposent fondamentalement sur l'architecture des transformers, qui permet de traiter du texte de manière contextuelle et parallélisée grâce à leur mécanisme d'attention.

Exemples

- Chatbots évolués (ex. : ChatGPT, Gemini).

- Rédaction automatisée (ex. : génération d'articles, de scripts).

- Aide à la programmation (ex. : GitHub Copilot suggérant du code).

9. Transformers (transformeur)

Architecture de réseaux de neurones révolutionnaire utilisant le mécanisme d'attention pour traiter des séquences de données (texte, audio, etc.) en parallèle, capturant les dépendances à long terme.

Exemples

- Traduction automatique (ex. : Google Translate).

- Modèles de langage (ex. : GPT-3, BERT).

- Analyse de documents (ex. : résumé de contrats juridiques).

10. Feature Engineering (ingénierie des caractéristiques)

Processus de sélection, transformation ou création de variables explicatives (features) pour améliorer la performance et l'interopérabilité des modèles d'IA. Cette étape est fondamentale en machine learning, où la qualité des features impacte directement la capacité d'un modèle à apprendre des motifs complexes à partir des données.

Exemples

- Création de variables temporelles (ex. : extraction du jour de la semaine depuis une date).

- Normalisation de données (ex. : conversion de prix en échelle logarithmique).

- Encodage de catégories (ex. : transformation de couleurs en valeurs numériques).

11. Supervised Learning (apprentissage supervisé)

Méthode d'IA où le modèle apprend à partir de données annotées (entrées + sorties attendues) pour prédire des résultats sur de nouvelles données.

Exemples

- Classification d'e-mails (spam vs. non-spam).

- Prédiction immobilière (estimer un prix basé sur superficie, localisation…).

- Reconnaissance de chiffres manuscrits (ex. : tri postal automatique).

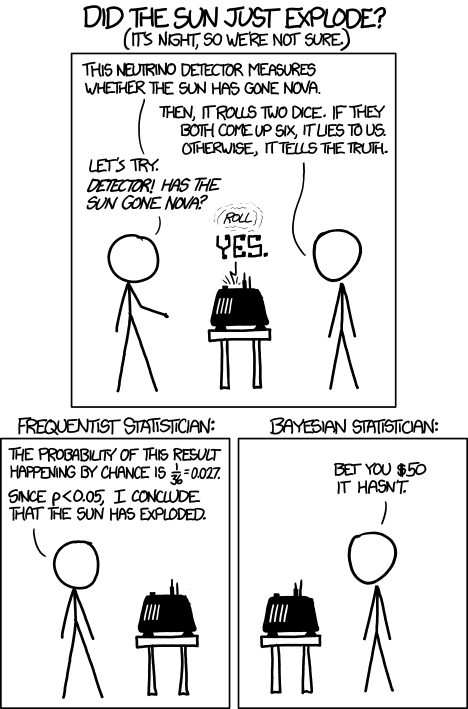

12. Bayesian Learning (apprentissage bayésien)

L'apprentissage bayésien est une approche probabiliste de l'IA qui combine des connaissances préalables (a priori) avec des données observées pour affiner des prédictions. Contrairement aux méthodes classiques, il quantifie explicitement l'incertitude via des distributions de probabilités, et les met à jour grâce au théorème de Bayes.

Applications clés

1. Filtrage anti-spam

- A priori : 20% des emails sont des spams.

- Données : Le mot "gratuit" apparaît dans 80% des spams historiques.

- Mise à jour : Si un nouvel email contient "gratuit", le modèle recalcule la probabilité qu'il soit un spam.

2. Diagnostic médical

- Un symptôme (ex. : fièvre) augmente la probabilité d'une maladie (ex. : grippe) en fonction de sa prévalence (a priori) et de sa spécificité (vraisemblance).

3. Recommandations personnalisées

- Prédire les préférences d'un utilisateur en combinant son historique (données) avec des tendances générales (a priori).

13. Prompt Engineering (ingénierie de prompt)

Art de formuler des instructions (prompts) précises et stratégiques pour guider les modèles génératifs vers des réponses pertinentes et contrôlées. Cette discipline est devenue cruciale avec l'avènement des LLMs, où la qualité du prompt détermine directement la performance du modèle, transformant une simple interaction en un véritable dialogue homme-machine optimisé.

Exemples

- Optimisation de requêtes. "Résume-moi cet article scientifique en 5 points clés, en utilisant un langage accessible à un lycéen" ➡️ Un LLM interprète mieux la double instruction (résumé + simplification) grâce à des marqueurs clairs.

- Création spécialisée. "Agis comme un expert en droit français. Rédige une clause de non-concurrence pour un contrat de travail, en moins de 150 mots." ➡️ Le prompt active des connaissances latentes du LLM tout en contraignant la forme.

→ Le prompt active des connaissances latentes du LLM tout en contraignant la forme.

14. AI Agents (agent IA)

Systèmes autonomes capables de percevoir leur environnement via des capteurs, de prendre des décisions via des algorithmes d'IA, et d'agir via des effecteurs. Ces agents atteignent des niveaux avancés d'autonomie lorsqu'ils sont combinés avec l'apprentissage par renforcement (RL), qui leur permet d'apprendre des comportements optimaux par essai-erreur dans des environnements complexes.

Exemples

- Assistants virtuels (ex. : Alexa planifiant un rendez-vous).

- Systèmes de recommandation (ex. : chatbot adaptant ses réponses) : Des agents conversationnels utilisent le RL pour améliorer leurs interactions en maximisant l'engagement utilisateur (récompense).

- Jeux vidéo (ex. : NPCs adaptant leur tactique en temps réel).

15. Fine-Tuning Models (ajustement de modèles)

Technique consistant à adapter un modèle pré-entraîné (ex: GPT, BERT) à une tâche ou un domaine spécifique en le ré-entraînant partiellement sur des données ciblées.

Exemples

- Chatbot médical (ex. : adaptation d'un LLM pour comprendre la terminologie médicale).

- Analyse de sentiments sectorielle (ex. : modèle optimisé pour les avis clients de restaurants).

- Reconnaissance d'objets spécialisés (ex. : détection de défauts sur des pièces industrielles).

16. Multimodal Models (modèles multimodaux)

Modèles d'IA capables de traiter et de croiser simultanément plusieurs types de données (texte, image, audio, vidéo) pour des tâches complexes.

Exemples

- Recherche par image (ex. : Google Lens identifiant un objet + fournissant une description textuelle).

- Génération vidéo à partir de texte (ex. : outils comme Veo de Google DeepMind).

- Assistants IA enrichis (ex. : générer des descriptions d'images pour les utilisateurs malvoyants).

17. Embeddings

Technique de conversion de données (mots, images, etc.) en vecteurs numériques denses, capturant leur sens ou similarité dans un espace géométrique.

Exemples

- Mots : "Roi" ➡️ vecteur proche de "Reine" (ex. : word2vec).

- Images : Photos de chats ➡️ regroupées dans un espace vectoriel similaire.

- Recommandations personnalisées : Netflix mappe films/utilisateurs dans un même espace.

18. Vector Search

Méthode de recherche qui compare des embeddings vectoriels pour trouver des éléments similaires dans une base de données, même sans correspondance textuelle exacte.

Exemples

- Moteurs de recommandation (ex. : "trouver des chaussures similaires à ce modèle").

- Recherche sémantique (ex. : requête "animal miauleur" ➡️ résultats sur les chats).

- Détection de plagiat (comparaison de vecteurs de textes).

19. Model Evaluation

Processus de mesure des performances d'un modèle d'IA à l'aide de métriques et de jeux de test pour garantir sa fiabilité et son adaptabilité.

Exemples

- Matrice de confusion (ex. : évaluer un classificateur spam/non-spam).

- Courbe ROC (ex. : analyser le compromis sensibilité/spécificité en médecine).

- Score BLEU (bilingual evaluation understudy) (ex. : qualité des traductions automatiques).

20. AI Infrastructure

Déployer des systèmes scalables pour supporter les opérations d'IA

L'infrastructure IA englobe les solutions matérielles et logicielles nécessaires pour développer, entraîner et déployer des modèles à grande échelle. Son rôle est critique : sans une architecture optimisée, même les algorithmes les plus avancés deviennent inutilisables en production.

Composants clés

- Calcul haute performance : Clusters de GPU/TPU (ex. : NVIDIA DGX pour l'entraînement).

- Orchestration : Outils comme Kubernetes ou Ray pour gérer des workloads distribués.

- MLOps : Plateformes (TFX, MLflow) automatisant le déploiement et le monitoring.

Exemple

OpenAI utilise des milliers de GPU NVIDIA A100 pour ChatGPT, combinés à des pipelines MLOps pour des mises à jour transparentes.

Sources (images)

ByteByteGo | EP167: Top 20 AI Concepts You Should Know

xkcd | Frequentists vs. Bayesians

xkcd | Tasks

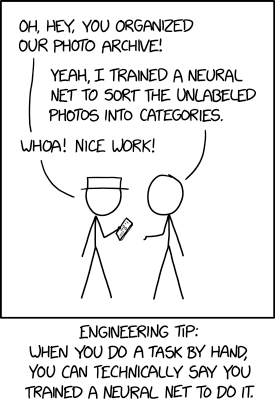

xkcd | Trained a Neural Net