Apache Airflow : Un outil d'orchestration de Workflows pour les Data Engineers

Découvrez Airflow, l'outil open-source pour gérer des pipelines complexes en Python (DAGs). Comparaison avec Control-M, nouveautés de la version 3 (DAG versioning, backfills, sécurité). Cas d'usage : ETL, ML, reporting. Puissant mais exigeant.

Introduction

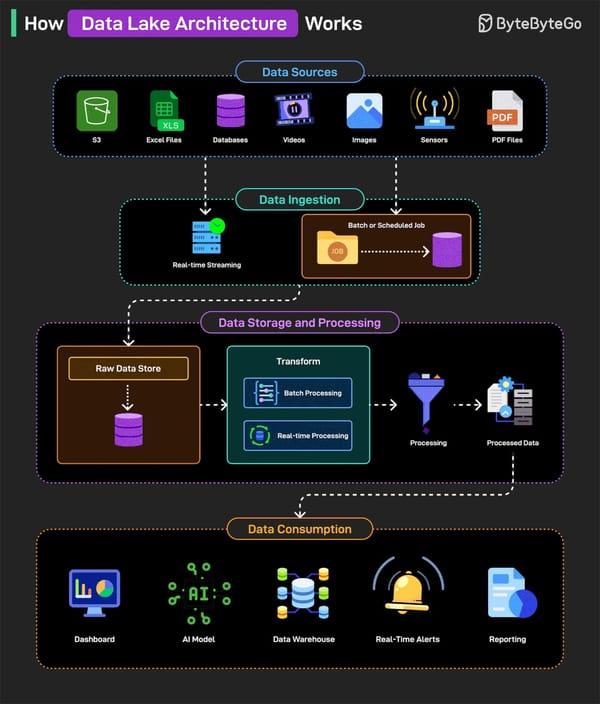

Dans l'écosystème moderne du Big Data, l'orchestration des pipelines de données est un enjeu critique pour garantir des workflows fiables, reproductibles et maintenables. Apache Airflow a émergé comme une solution open-source largement adoptée pour répondre à ce besoin, bien qu'elle ne soit pas l'unique option disponible. Initialement développé par Airbnb en 2014, Airflow permet de programmer, surveiller et gérer des workflows complexes sous forme de Directed Acyclic Graphs (DAGs). Dans cet article, nous explorerons le rôle d'Airflow, ses avantages par rapport à un outil comme Control-M, ses cas d'usage, et les nouveautés de la version 3.

Qu'est-ce qu'Apache Airflow ?

Apache Airflow est une plateforme d'orchestration de workflows conçue pour les pipelines de données. Contrairement aux ordonnanceurs traditionnels comme Control-M, Airflow offre :

- Déclaration des workflows en code (Python) : Les pipelines sont définis sous forme de scripts Python, ce qui permet un meilleur versioning et une intégration avec les outils modernes de développement.

- DAGs (Directed Acyclic Graphs) : Les workflows sont modélisés sous forme de graphes acycliques dirigés, garantissant des dépendances claires entre les tâches.

- Interface riche : Une interface web intuitive pour surveiller et dépanner les workflows.

- Extensibilité : Une large bibliothèque d'opérateurs pour interagir avec des services comme AWS, GCP, Kafka, etc.

Origine et adoption

- Créé par Airbnb en 2014 pour répondre à des besoins internes d'orchestration.

- Adopté par des entreprises comme Lyft, PayPal et Twitter pour gérer des pipelines complexes.

- Intégré à l'écosystème Big Data avec des connecteurs pour Spark, Hive, Snowflake, et bien d'autres.

Airflow vs Control-M : Un comparatif clé

(Orchestrateur vs Ordonnanceur – des outils différents mais complémentaires)

| Critère | Apache Airflow (Orchestrateur) | Control-M (Ordonnanceur) |

|---|---|---|

| Rôle principal | Orchestration de workflows data (ETL, ML, etc.) | Ordonnancement de workflows métiers (batch, ERP, mainframe) |

| Modèle de définition | Code (Python) – Flexible et versionné | Configuration via interface graphique ou fichiers |

| Ciblage technique | Équipes Data (Python, Big Data, Cloud) | Équipes IT traditionnelles (mainframe, SAP, etc.) |

| Gestion des dépendances | Dynamiques (DAGs) – Adapté aux flux data complexes | Statiques (dépendances temps/événements simples) |

| Cas d'usage typique | Pipeline ML, synchronisation de données, reporting data | Jobs bancaires, paie, ERP |

Pourquoi ces outils peuvent être complémentaires ?

- Exemple concret :

- Un job Control-M (ex : extraction mensuelle SAP) peut déclencher un DAG Airflow pour nettoyer/analyser ces données.

- Airflow gère les tâches data (complexes), Control-M assure la fiabilité des processus métiers (critiques).

- Avantages combinés :

- Control-M : Auditabilité, conformité, gestion fine des priorités.

- Airflow : Flexibilité, intégration avec les outils data modernes.

Note : Airflow n’est pas un remplacement de Control-M, mais un outil pour des besoins différents (data vs métier).

Pourquoi choisir Airflow ?

Airflow se distingue comme le choix privilégié pour les pipelines de données modernes, notamment lorsqu'une intégration avec des outils comme Spark, Kafka ou des services cloud est nécessaire. Control-M reste une option robuste pour les environnements traditionnels où la gestion des workflows métiers est prioritaire.

Fonctionnalités clés d'Airflow

1. Définition des workflows en Python

Airflow permet de définir les workflows sous forme de code Python, ce qui offre plusieurs avantages :

- Versioning : Les DAGs peuvent être versionnés avec Git.

- Testabilité : Les pipelines peuvent être testés comme n'importe quel autre code Python.

- Flexibilité : Possibilité d'intégrer des logiques complexes directement dans les workflows.

2. Interface web riche

L'interface web d'Airflow permet de :

- Visualiser les DAGs : Comprendre facilement les dépendances entre les tâches.

- Surveiller les exécutions : Voir l'état des tâches en temps réel.

- Dépanner : Accéder aux logs et relancer des tâches si nécessaire.

3. Gestion des dépendances et reprise sur erreur

Airflow gère nativement :

- Les dépendances entre tâches : Une tâche ne s'exécute que si ses dépendances sont satisfaites.

- La reprise sur erreur : Possibilité de relancer automatiquement les tâches en échec.

Les nouveautés d'Airflow 3

La version 3 d'Apache Airflow apporte des améliorations majeures :

1. DAG versioning

Historique des modifications : Chaque exécution de DAG est liée à la version exacte du code utilisée, facilitant le débogage et la conformité.

2. Backfills managés

Gestion simplifiée : Les backfills peuvent être déclenchés, surveillés et annulés via l'interface web ou l'API, sans dépendre de sessions CLI.

3. Sécurité renforcée

Découplage de l'exécution : Les tâches communiquent via une API sécurisée, réduisant les risques et permettant une exécution distante.

4. Prise en charge du temps réel

Scheduling événementiel : Possibilité de déclencher des DAGs en réponse à des événements (nouveau fichier dans un bucket S3, message dans une queue, etc.).

Cas d'usage pratiques

1. Orchestration de pipelines ETL

- Problème : Automatiser l'extraction, transformation et chargement de données depuis diverses sources.

- Solution Airflow : Définir un DAG pour chaque pipeline, avec des tâches pour chaque étape (extraction, transformation, chargement).

2. Entraînement de modèles de ML

- Problème : Orchestrer des workflows complexes de préprocessing et d'entraînement.

- Solution Airflow : Utiliser des DAGs pour gérer les dépendances entre les étapes et surveiller les exécutions.

3. Reporting automatisé

- Problème : Générer et distribuer des rapports périodiques.

- Solution Airflow : Créer un DAG pour extraire les données, générer les rapports et les envoyer par email.

Les limites d'Airflow

Comme souligné dans la vidéo "Don't Use Apache Airflow", Airflow présente certaines limites :

- Pas une solution ETL : Airflow est un orchestrateur, pas un outil ETL. Il ne fournit pas de fonctionnalités natives pour transformer ou déplacer des données.

- Complexité : La courbe d'apprentissage est raide, surtout pour les débutants.

- DAGs principalement en Python : Bien que les DAGs soient définis en Python, Airflow permet d'exécuter des tâches dans d'autres langages (Bash, SQL, etc.) via des opérateurs dédiés.

- Surcharge opérationnelle : Airflow nécessite une infrastructure dédiée (base de données, workers, etc.).

Quand utiliser Airflow ?

Airflow est particulièrement adapté pour :

- Les pipelines complexes avec de nombreuses dépendances.

- Les environnements cloud où l'intégration avec des services comme AWS ou GCP est nécessaire.

- Les équipes DevOps/Data familiarisées avec Python.

En revanche, pour des besoins simples d'ETL, des outils comme Apache NiFi ou des solutions cloud (AWS Glue, Azure Data Factory) peuvent être plus appropriés.

Conclusion : Airflow, un outil puissant mais exigeant

Airflow s’impose comme une solution robuste pour l’orchestration de workflows de données complexes, grâce à sa flexibilité (DAGs en Python), son écosystème étendu et ses fonctionnalités avancées comme le versioning ou le scheduling événementiel. Cependant, son adoption nécessite une maîtrise technique, notamment en Python et en gestion d’infrastructure, et convient moins à des besoins simples.

Recommandation clé

Choisissez Airflow si vos pipelines sont complexes et nécessitent une orchestration fine. Pour des workflows plus légers, évaluez d’abord la courbe d’apprentissage et l’effort opérationnel requis. Son vrai potentiel se révèle dans les environnements techniques matures.